Dupliquer sans se fatiguer : Le Mirroring de Microsoft Fabric c’est quoi ?

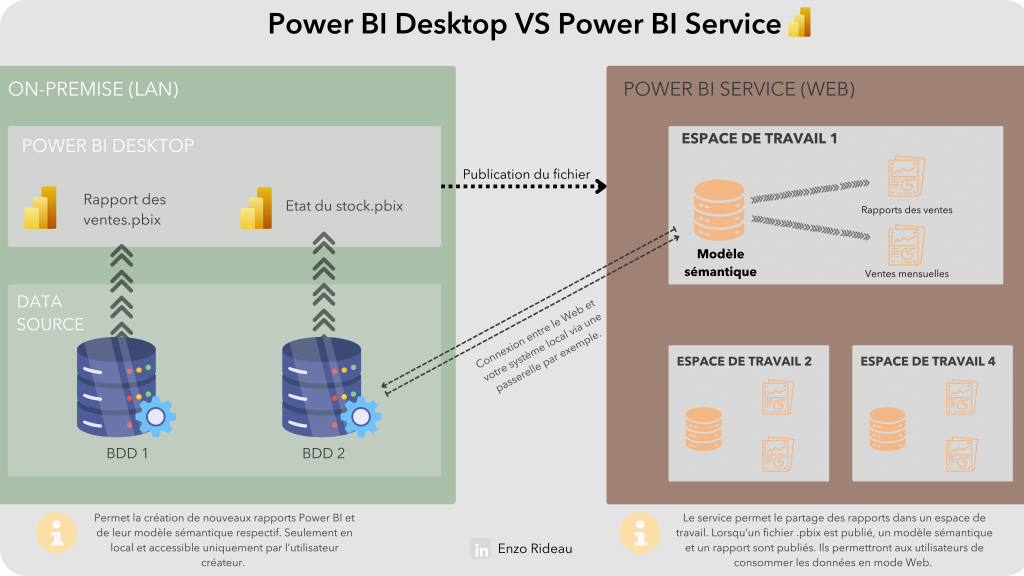

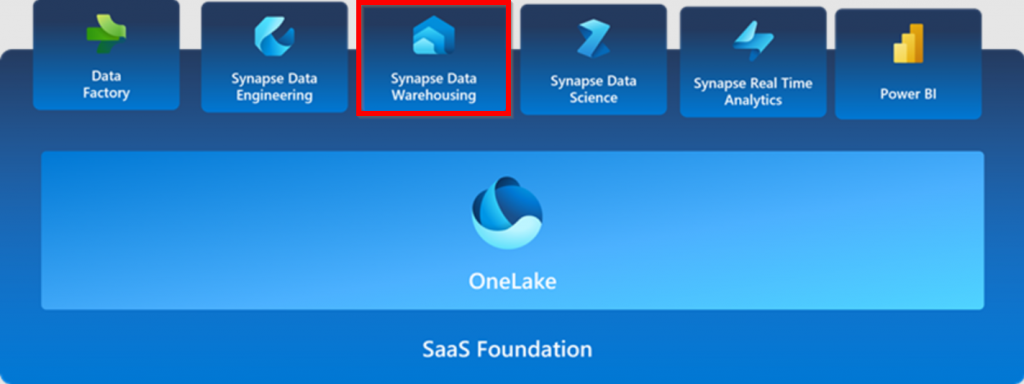

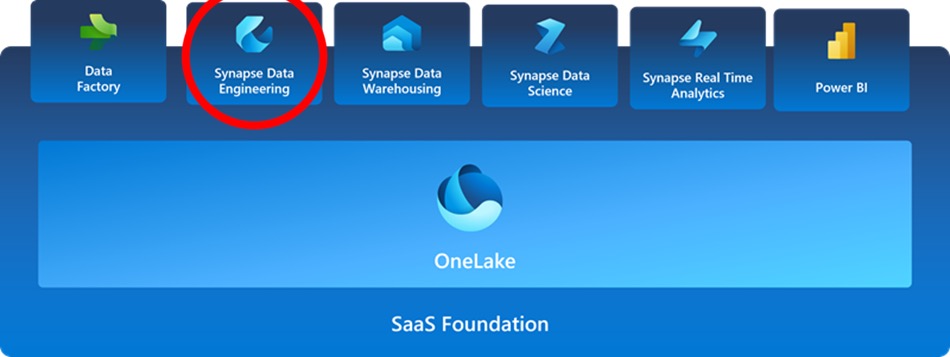

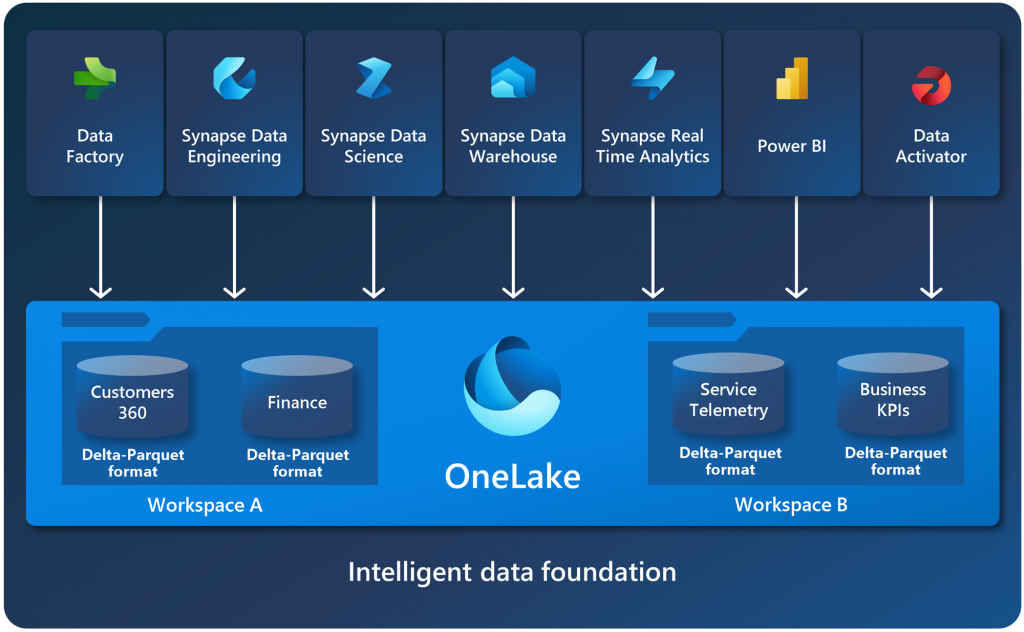

La fonctionnalité de « Mirroring » dans Microsoft Fabric transforme radicalement la gestion traditionnelle des données. Cette fonction permet une duplication automatique des données depuis une source primaire, telle qu’une base de données Azure SQL ou Snowflake, directement dans OneLake, sans nécessiter l’intervention manuelle habituelle des processus ETL.

Voici une explication détaillée de ce que le Mirroring dans Microsoft Fabric implique et comment il fonctionne, avec un exemple concret :

- Réplication en quasi-temps réel : La mise en miroir dans Microsoft Fabric réplique vos données en continu. Par exemple, considérez une entreprise de e-commerce qui utilise Azure SQL pour stocker les transactions de vente. Avec le mirroring, ces données sont automatiquement et constamment répliquées dans OneLake, garantissant que les données sont toujours actuelles et prêtes pour l’analyse.

- Utilisation avec d’autres services de Fabric : Une fois les données répliquées dans OneLake, elles sont disponibles pour être analysées ou traitées avec d’autres services Fabric, tels que Spark ou Power BI. Cela permet aux analystes de visualiser les tendances des ventes en temps réel sans délai.

- Simplicité et intégration : Le mirroring est conçu pour une intégration transparente dans l’écosystème Microsoft, facilitant l’utilisation conjointe de divers services et outils. Cette intégration aide les entreprises à adopter de nouvelles méthodes de gestion des données sans friction notable.

- Réduction des coûts et de la latence : En éliminant les processus ETL manuels, le mirroring réduit non seulement les coûts opérationnels mais aussi la latence, permettant ainsi des décisions plus rapides et plus économiques basées sur des données actualisées.

- Avantages supplémentaires : En stockant les données dans un format prêt pour l’analytique, le mirroring facilite des scénarios en aval tels que l’ingénierie et la science des données, optimisant l’utilisation des ressources et maximisant les insights tirés des données.

Limitation actuelle : Pour l’instant, les sources de données compatibles avec le mirroring dans Microsoft Fabric sont limitées. Actuellement, seules quelques sources comme Azure SQL Database, Azure Cosmos DB et Snowflake sont supportées. Toutefois, nous espérons voir une extension de cette liste dans les prochaines mises à jour pour inclure une gamme plus large de sources de données.

En conclusion, la mise en miroir dans Microsoft Fabric offre une méthode efficace et moderne pour centraliser et simplifier la gestion des données. Cette solution aide les entreprises à réduire la complexité et à améliorer l’efficacité des analyses, en transformant la manière dont elles accèdent et utilisent les informations.

PS : en plus Microsoft offrent de l’espace de stockage gratuit pour la fonctionnalité mise en miroir ! 😉